xshell ssh 연결하기 xshell ssh 서버 로그인 -> docker start 컨테이너이름 -> docker attach 컨테이너이름 파이참 ssh 연결하기 파이참 프로젝트 생성 -> 상단 File 클릭 후 Setting -> Deployment SSH configuration 연결 -> Root path /작업공간 이름 지정 -> Mappings 클릭 후 Deployment path 설정 파이참 프로젝트 도커에 올리기 좌측 해당 프로젝트 or 파일 우클릭 -> Deployment -> upload to ~~ (자동화) 상단 Tools -> Deployment -> Automatic upload ssh 원격 서버에서 python 실행하기 일반적인 실행 - python 파일이름.py (기본 GP..

딥러닝 검색 결과

1. Introduction 기존으 NLP모델은 labeled된 데이터를 바탕으로 지도학습을 했다. 하지만 존재하는 데이터는 unlabeled data가 훨씬 많기 때문에, unlabeled data의 정보를 활용한다면 훈련에 필요한 시간과 비용을 절약할 수 있다. 하지만 unlabeled data의 정보를 활용하는 것이 힘든 이유는 크게 두가지가 있다. 1) 어떤 목적함수(Optimization objective)가 효과적인지 알 수 없다. 2) 모델에서 학습된 표현(reprentation)을 다양한 NLP task로 전환하는데 가장 효율적인 방법이 정해지지 않았다. GPT-1은 이 두 가지 단점을 보완하고자 하였는데, 먼저 unsupervised로 pre-training하고 supervised로 fi..

Attention을 소개하기 앞서 NLP의 발전과정에 대해 설명하겠습니다. 먼저 첫 번째로 RNN은 Neural network에서 recurrent 순환형 구조를 추가한 것, LSTM은 기존 RNN이 역전파가 길어질 시 단점이 생겨 hidden state에 cell-state를 추가하여 발전시킨 것입니다. Seq2Seq2는 RNN을 구조를 사용해서 인코더, 디코더 구조로 변환해서 번역 수행하였습니다. Attention은 모든 입력 시퀀스를 참고. Transformer는 RNN, CNN사용 안하고 Attention만 사용. 그리고 Transformer의 인코더를 활용한게 GPT, Transformer의 디코더를 활용한게 BERT모델입니다. 그만큼 Transformer는 매우 중요합니다. 그리고 여기서 점선..

nicknochnack/ANPRwithPython Contribute to nicknochnack/ANPRwithPython development by creating an account on GitHub. github.com 0. Install and Import Dependencies pip install easyocr pip install imutils # OMP: ERROR #15: Initializing libiomp5md.dll, but found libiomp5md.dll already initialized. import os os.environ['KMP_DUPLICATE_LIB_OK']='True' import cv2 from matplotlib import pyplot as plt im..

논문 : arxiv.org/abs/1802.05365 논문 제목 : Deep contextualized word representations 1. Introduction ELMo가 세상에 나오기 전에 Word2Vec과 Glove가 대표적인 단어 임베딩 방법이었습니다. 여기서 단어 임베딩이란 단어의 의미를 숫자로 표현한 것인데, 선행학습된 임베딩이 NLP의 성능 발전에 큰 영향을 주었습니다. 자연어처리 분야는 데이터가 굉장히 많이 들어가는데, 이 단어 임베딩을 함으로써 더 많은 단어들을 이해하기 때문에 단어 임베딩은 매우 중요합니다. 이 이유는 단어 임베딩을 선행 레이어부터 시작하면, 학습의 속도도 적어지고 단어 임베딩을 하지 않고 학습한다면 학습 도중에 단어 임베딩을 해야하기 때문에 시간이 굉장히 많이 ..

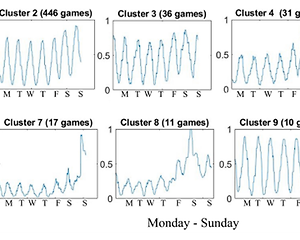

1. 주간 인구 패턴 검색 1) 데이터 선택 이전 글 [논문 Review] 온라인 게임의 주간 플레이어 인구 패턴 1에서 제시한 것처럼, 모든 게임에서 플레이어 수의 변동이 주간별 계절성을 보이는 것은 아니다. 그래서 이 클러스터링 과정에는 조각별 선형 추세 제거 기술이 적용 후 계절성이 나타난 1508개의 게임만 사용되었다. 또한, 주간 플레이어의 변동 패턴을 나타내기 위해서는 각 게임의 시계열 데이터에서 플레이어 수가 일주일 내에 어떻게 변동하는지에 대한 모집단 데이터를 추출해야 한다. 그런데, 게임마다 업데이트나 경쟁 등 다양한 이벤트로 인해 추세가 나타날 수도 있기에 0에 가장 가까울 정도의 낮은 추세를 가진 segment에서 데이터를 추출하며, 추세 제거 방법에는 piecewise 선형 제거를 ..

1. Intro 2018년 기준, 전 세계 게임 플레이어 수는 23억 명 이상이 될 정도로 게임 산업이 성장했다. 해당 논문은 플레이어의 행동을 바탕으로 1주일이라는 프레임 내에서의 게임 플레이어 수의 변동 패턴에 대한 내용을 다뤘다. 2. 관련 선행 연구 1) 플레이어의 행동을 기반으로 한 다른 플레이어의 행동 프로파일링 2) 시계열 클러스터링을 사용하여 게임 이벤트와 플레이어의 구매 행동 중 다양한 게임 활동 패턴 발견 3) 게임 플레이 시간과 게임 특성에 따라 6개 그룹의 게이머 프로필 식별 이 외에도, 원격 측정을 사용하여 플레이어의 여러 행동 패턴을 연구한 사례 등 다양한 선행 연구가 있다. 그러나 주간 패턴이나 일반적인 플레이어의 변동 패턴에 대해 다룬 사례가 많지는 않다. 그렇기에 해당 연구..

정규화 방법론 선형회귀 분석을 통해서 계산된 계수(Weight)에 대한 제약 조건을 추가함으로써 과적합(Overfiiting)을 방지하는 방법 일반적으로 과적합은 계수의 크기를 엄청나게 증가시키는 경우에 많이 발생하므로, 정규화 방법론에서 사용하는 제약 조건은 계수의 크기를 제한하는 방법이 많이 사용된다. 참고> argmin 앞으로 선형 회귀 등 여러 기계학습 알고리즘을 접하다 보면, argmin이라는 기호를 접할 때가 있다. argmin은 뒤의 식을 최소로 만드는 해당 변수의 값을 찾아낼 때 사용하는 것으로 대괄호 안에 있는 식은 ( x - 1) ^ 2이므로, x = 1인 경우에 최솟값 0을 가진다. 이런 경우에 x_hat에는 대괄호 안에 있는 식을 최솟값으로 만드는 x의 값인 1을 x_hat에 할당한..

"시계열이 정상성이다." : 시간의 흐름에 따라 '통계적 특성'이 변하지 않는다. 비정상성을 지니는 데이터를 정상화 알고리즘을 적용해 예측 본 데이터의 특성을 적용하여 다시 본 데이터의 특성을 가지는 상태에서의 예측값을 도출 정상성 변환을 하는 이유 일반적인 경우에, 예측 범위의 상한, 하한이 정해져 있지 않다. 하지만, 정상성 변환 과정을 거치면 상한과 하한이 어느정도 예측 가능한 범위 내로 좁혀지게 된다. 이것 외에도 Variance나 Autocorrelation 등의 고려 요소도 사라지게 된다. 중요한 것은 정상성 그 자체보다는 정상성을 하는 이유가 더 중요하다. 정상성은 한가지 수단에 불과하고, 정상성 변환을 하는 이유로 다른 수단을 사용할 수 있어야 한다. 강정상, 약정상 강정상 : 모든 통계량..

NLP 논문리뷰 논문제목 : Enriching Word Vectors with Subword Information 논문링크 : arxiv.org/abs/1607.04606 1. Abstract & information 기존 모델은 단어마다 다른 벡터를 할당하여 단어의 형태를 무시한다. 위와 같은 문제점을 해결하기 위해 Skip-gram을 기반으로 한 모델에 각 단어를 character n-gram 벡터의 조합으로 표현하였다. 그랬더니 학습 속도가 빠르고, 학습 데이터에 등장하지 않은 단어도 표현이 가능해졌다. 9개 언어에 대해 단어 유사도 및 추론 태스크를 통해 평가했더니 SOTA(state-of-the-art)를 달성하였다. 기존 모델은 parameter를 공유하지 않는 다른 벡터로 단어를 표현하였다...

최근댓글